一、HBM产业概述

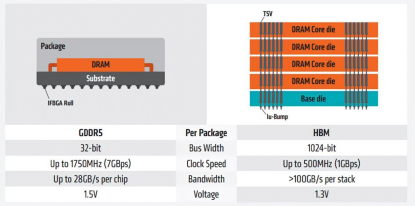

一场AI引发的算力革命,让原本GDDR5的带宽无法满足AI计算的需求,阻碍了GPU的性能增长。在芯片设计中,缓存要占芯片60%左右的面积,存储结构和工艺制约了GPU的进一步发展,HBM的出现使AI深度学习完全放到芯片上成为可能,从而解决了芯片性能提升的瓶颈。

HBM( High Bandwidth Memory)是一种高带宽DRAM内存芯片,采用3D堆叠工艺,由多个DRAM Die垂直堆叠,具备高带宽、高容量、高传输及低延时、低功耗等特点。其被广泛应用于高性能计算、数据中心、人工智能等领域。

图表1:GDDR5与HBM结构图区别

资料来源:AMD

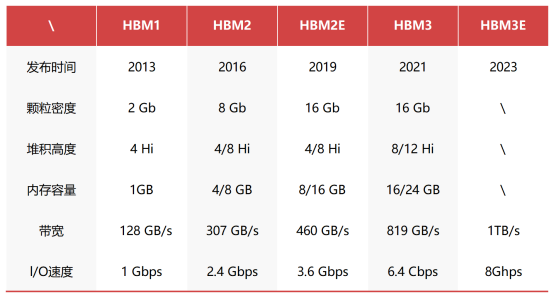

回看HBM的发展,资料显示,该技术从2013年开始出现在半导体市场,且已经扩展到第一代(HBM)、第二代(HBM2)、第三代(HBM2E)、第四代(HBM3),目前是第五代(HBM3E)。

图表2:HBM技术性能发展

资料来源:Wikipedia, SK Hynix, DEPEND整理

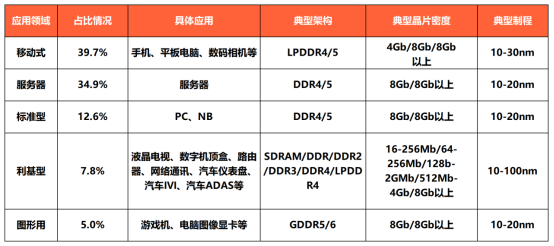

在DRAM细分产品中,DDR应用服务器和PC端;GDDR应用图像、数据密集型;LPDDR应用于手机消费电子,HBM则在超级计算机、人工智能、AI服务器等新型高算力领域发力。

图表3:全球DRAM下游应用占比及规格情况

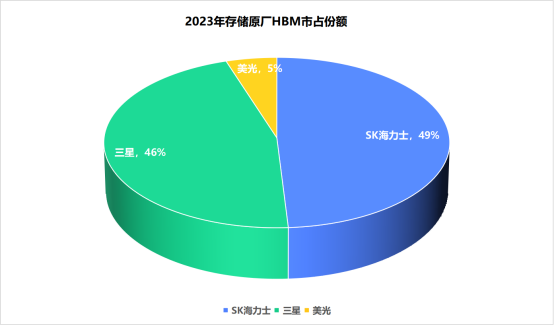

由于HBM高门槛,目前仅SK海力士、三星和美光稳定供应。2022年三者份额分别为50%、40%、10%。其中海力士占据先发优势,更于2023年5月率先推出了HBM3E,宣布将于2023年下半年发布样品,2024 年上半年投入生产。

TrendForce的数据显示,三星和SK海力士预计2023年将分别占据HBM46%和49%的市场份额,美光将在2023年占据其余市场份额。三星预计今年年底或明年年初正式供应HBM3。

图表4:2023年存储原厂HBM市占份额情况

二、HBM市场洞察

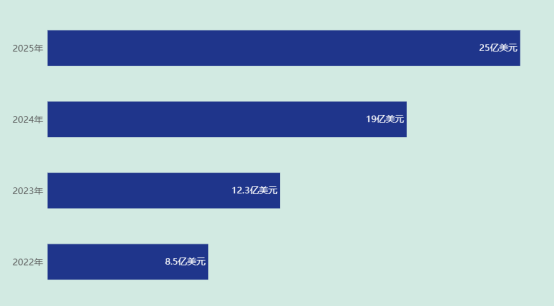

HBM目前约占整个DRAM市场的1.5%。集邦咨询预计2023年HBM需求量将年增58%,2024年30%。Omdia则预计,2025年HBM市场总收入可达25亿美元。

图表5:2022-2025年HBM市场总收入预估

资料来源:Omdia, DEPEND整理

从成本端来看,HBM的平均售价至少是DRAM的三倍,此前受ChatGPT的拉动同时受限产能不足,HBM的价格一路上涨,与性能最高的DRAM相比HBM3的价格上涨了五倍。

出货能力方面,据SK海力士预计,2024年HBM和DDR5的销售额有望翻番。NVIDIA的HBM需求预计将从2023年大约1200万颗翻倍增长到2024年2400万颗。SK海力士预估2023年HBM出货量50万颗,2024年HBM3和HBM3E产品供应量都在增加,并已完全售罄。三星和SK海力士正准备将HBM产量提高至2.5倍。

而且,随着大型互联网客户自研AI芯片陆续推出,HBM客户群预计将大幅扩容。除了NVIDIA之外,HBM的潜在客户数量也在快速增加,其中包括Google、AWS和Meta等正在积极自研AI芯片的科技巨头。