1.HBM产业概述

1.1.产品描述

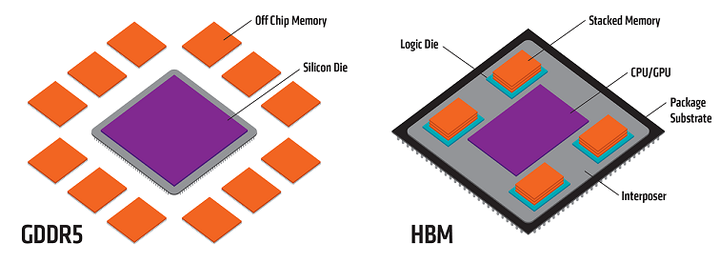

HBM是通过垂直堆叠DRAM且和GPU绑定封装后,实现高速、大容量、低延迟、低功耗的DDR组合阵列。

图表 1:HBM与GDDR5产品比较

HBM和DRAM(Dynamic Random Access Memory,动态随机存取存储器)同属于“RAM类型”。RAM(Random Access Memory,随机存取存储器)是计算机的主内存,用于临时存储正在运行的程序和当前使用的数据。

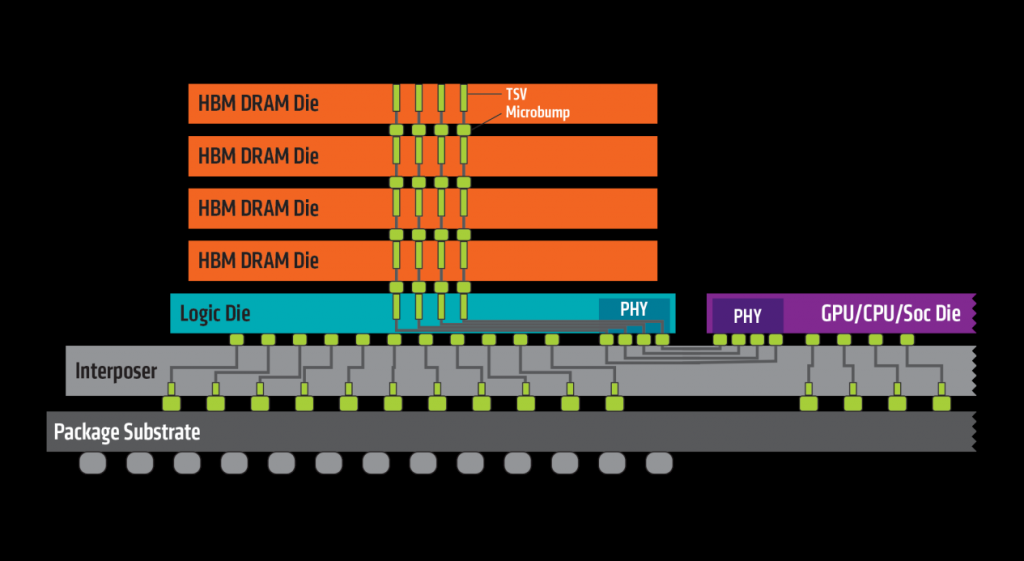

HBM分为2个stack,每个stack有8通道,每个通道可以分为2个伪通道(pseudo channel),一共有32个pseudo channel。HBM存储大小分为64Gb和128Gb,因此最大为16GB。

图表 2:HBM产品结构

HBM特点:

- HBM堆栈不通过外部互连线的方式与GPU/CPU/SoC连接,而是通过中间介质层紧凑快速地连接信号处理器芯片。与传统的冯诺依曼计算架构相比,HBM通过堆叠多层DDR提供大量并行处理能力获得极高的存储器带宽,并使得数据参数距离核心计算单元更近,有效降低数据搬运的延迟和功耗。

- 在芯片设计上,HBM是通过中间介质层紧凑快速地连接,使得其在节省空间方面也独具一格,让CPU/GPU产品更轻便。

- 因为HBM需要大量DRAM进行堆叠,因此它的制造需要更高的工艺和技术,成本也随之上升,而如何更快地散热也是其设计、制造面临的挑战。

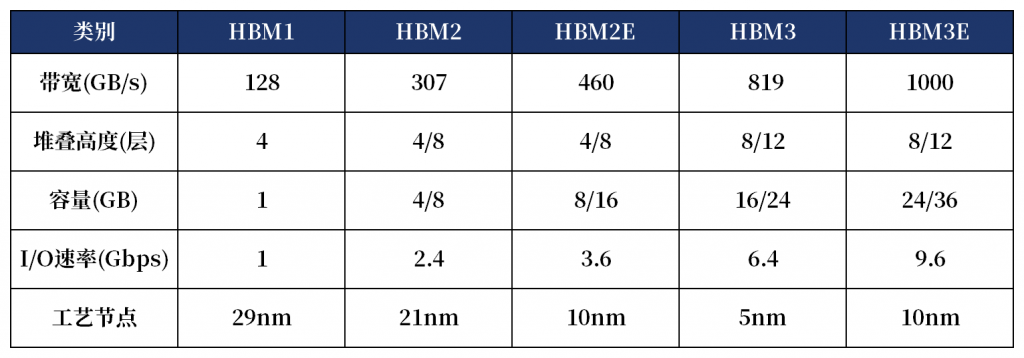

HBM分类:目前,HBM产品以HBM(第一代)、HBM2(第二代)、HBM2E(第三代)、HBM3(第四代)、HBM3E(第五代)的顺序开发,最新的HBM3E是HBM3的扩展版本。GPU现在一般常见有2/4/6/8四种数量的堆叠,立体上目前最多堆叠12层。

图表 3:HBM产品系列参数对比

1.2.市场行情

规模:预计2024年HBM产值将翻4倍,达到169亿美元。集邦咨询数据显示,2023年HBM产值占DRAM整体产业约8.4%,市场规模约43.56亿美元;预估至2024年底将达169.14亿美元,占DRAM整体产值约20.1%。

高盛也指出,从2023年到2026年,HBM市场规模将以接近100%的年复合增长率(CAGR)增长,到2026年达到300亿美元。

价格:HBM销售单价较传统型DRAM高出数倍,相较DDR5价差大约五倍。以英伟达H100为例,H100配套5颗HBM2E,单颗HBM2E容量16GB,8层堆叠、每层堆叠2GB,每颗H100需要80GB HBM2E,HBM2E每GB单价10-20美金。英伟达H100成本接近3000美元,其中HBM2E成本约为1600美元左右,大幅超过制造和封装环节。

产能:2024年SK海力士和三星HBM平均月产能8.5万片,美光1.2万片。从目前来看三大存储芯片大佬SK海力士、美光及三星今年的HBM供应能力已全部耗尽,明年的产能已经大部分售罄。据专业机构分析,今明两年HBM需求的动态缺口约为产能的5.5%和3.5%。

需求:HBM当前的最终产品主要是AI服务器,而云服务厂商才是最终的消费者(掏钱方)。HBM主要应用场景为AI服务器,最新一代HBM3e搭载于英伟达2023年发布的H200。根据集邦咨询数据,2022年AI服务器出货量86万台,预计2026年AI服务器出货量将超过200万台,年复合增速29%。AI服务器出货量增长催化HBM需求爆发。

1.3.主要企业

HBM芯片“三分天下”,供给厂商主要聚焦SK海力士、三星及美光,2024年三大巨头皆有望量产第五代HBM3E。中国厂商可关注武汉新芯(XMC)和长鑫存储(CXMT),目前处于建设阶段,未量产HBM。